روشی جدید برای کنترل هوش مصنوعی

محققان روش جدیدی را برای پاک کردن اطلاعات مضر از سیستمهای هوش مصنوعی توسعه دادهاند.

به گزارش راهبرد معاصر؛ هوش مصنوعی (AI)، مانند سایر فناوریها مانند ویرایش ژن و انرژی هستهای، میتواند برای اهداف خوب یا بد استفاده شود. با این همه پول و تلاش برای توسعه هوش مصنوعی با چنین سرعتی، نگرانیهایی در مورد استفاده از مدلهای زبانی بزرگ (LLM) (سیستمهای هوش مصنوعی که برای درک و پاسخگویی به زبان انسان طراحی شدهاند) برای مقاصد مضر مانند توسعه سلاح وجود دارد.

برای کاهش این خطرات، سازمانهای دولتی و آزمایشگاههای هوش مصنوعی سعی میکنند دقیقا بدانند که مدلهای زبانی بزرگ، تا چه میزان قادر به درک و تولید محتوا در موضوعاتی حساس مانند امنیت زیستی، سایبری و شیمیایی هستند.

گروهی از کارشناسان یک معیار جدید برای سنجش خطر هوش مصنوعی به نام مجموعه دادههای پروکسی سلاحهای کشتار جمعی (Weapons of Mass Destruction Proxy) یا به اختصار WMDP ایجاد کردهاند. این نه تنها روشی را برای بررسی میزان اطلاعات خطرناک هوش مصنوعی ارائه میدهد، بلکه راهی م برای حذف این دادهها و اطلاعات دارد.

محققان با مشاوره با کارشناسان امنیت زیستی، سلاحهای شیمیایی و امنیت سایبری کار خود را آغاز کردند. این متخصصان تمام راههای احتمالی آسیبرسان در حوزه تخصص خودشان را فهرست کردند. سپس، ۴۰۰۰ سوال چندگزینهای طراحی کردند تا دانش فرد را در مورد چگونگی ایجاد این آسیبها بیازماید و مطمئن شدند که سوالات هیچ اطلاعات حساسی را به اشتراک نمیگذارد.

مجموعه داده WMDP دو هدف اصلی را دنبال میکند: اول، به عنوان راهی برای ارزیابی میزان درک LLMها از موضوعات خطرناک، و دوم، به عنوان معیاری برای توسعه روشهایی برای حذف این اطلاعات از هوش مصنوعی.

این تیم همچنین یک روش یادگیری جدید به نام کات را معرفی کرده که همانطور که از نامش پیداست، دانش خطرناک را از LLM حذف میکند و در عین حال تواناییهای کلی آنها را در زمینههای دیگر مانند زیستشناسی و علوم کامپیوتر حفظ میکند.

به طور کلی هدف، ارائه ابزاری برای محققان به منظور ارزیابی و رسیدگی به خطرات مرتبط با استفاده از LLM برای اهداف مضر است.

دن هندریکس، مدیر اجرایی مرکز ایمنی هوش مصنوعی و اولین نویسنده این مطالعه، به تایم گفت: امید ما این است که این روش به عنوان یکی از معیارهای اصلی برای توسعهدهندگان هوش مصنوعی استفاده شود و این ابزار چارچوب خوبی برای به حداقل رساندن خطر باشد.

کاخ سفید نگران استفاده از هوش مصنوعی توسط عوامل مخرب برای توسعه سلاحهای خطرناک است و خواستار توسعه روشهایی برای برطرف کردن خطر احتمالی است.

در اکتبر ۲۰۲۳، جو بایدن، رئیس جمهور ایالات متحده، فرمانی اجرایی را با هدف اطمینان از اینکه ایالات متحده نقشی پیشرو در استفاده از پتانسیل و رسیدگی به خطرات مرتبط با هوش مصنوعی ایفا میکند، امضا کرد.

این فرمان اجرایی هشت اصل و اولویت راهنما برای استفاده مسئولانه از هوش مصنوعی، از جمله ایمنی، امنیت، حریم خصوصی، برابری، حقوق مدنی، حمایت از مصرفکننده، توانمندسازی کارگران، نوآوری، رقابت و رهبری جهانی را ترسیم میکند./همشهری آنلاین

رئیسی دستور داده تا 3 میلیارد یورو در اختیار نیروهای مسلح قرار داده شود

رئیسی دستور داده تا 3 میلیارد یورو در اختیار نیروهای مسلح قرار داده شود  زشتی 9 ملکه زیبایی جهان بدون آرایش ! + عکس های قبل و بعد از مسابقه

زشتی 9 ملکه زیبایی جهان بدون آرایش ! + عکس های قبل و بعد از مسابقه  سوپر گل آلومینیوم به پرسپولیس +فیلم

سوپر گل آلومینیوم به پرسپولیس +فیلم  هیچگاه موز و تخم مرغ را باهم نخورید

هیچگاه موز و تخم مرغ را باهم نخورید  بهترین و زیباترین شعر درباره جشن خودکار برای کلاس سوم و چهارم ابتدایی

بهترین و زیباترین شعر درباره جشن خودکار برای کلاس سوم و چهارم ابتدایی  معما / زیر 10 ثانیه نسبت فامیلی ما رو حدس بزنید !!

معما / زیر 10 ثانیه نسبت فامیلی ما رو حدس بزنید !!  دانلود آهنگ جشن الفبا کلاس اول عمو مسعود

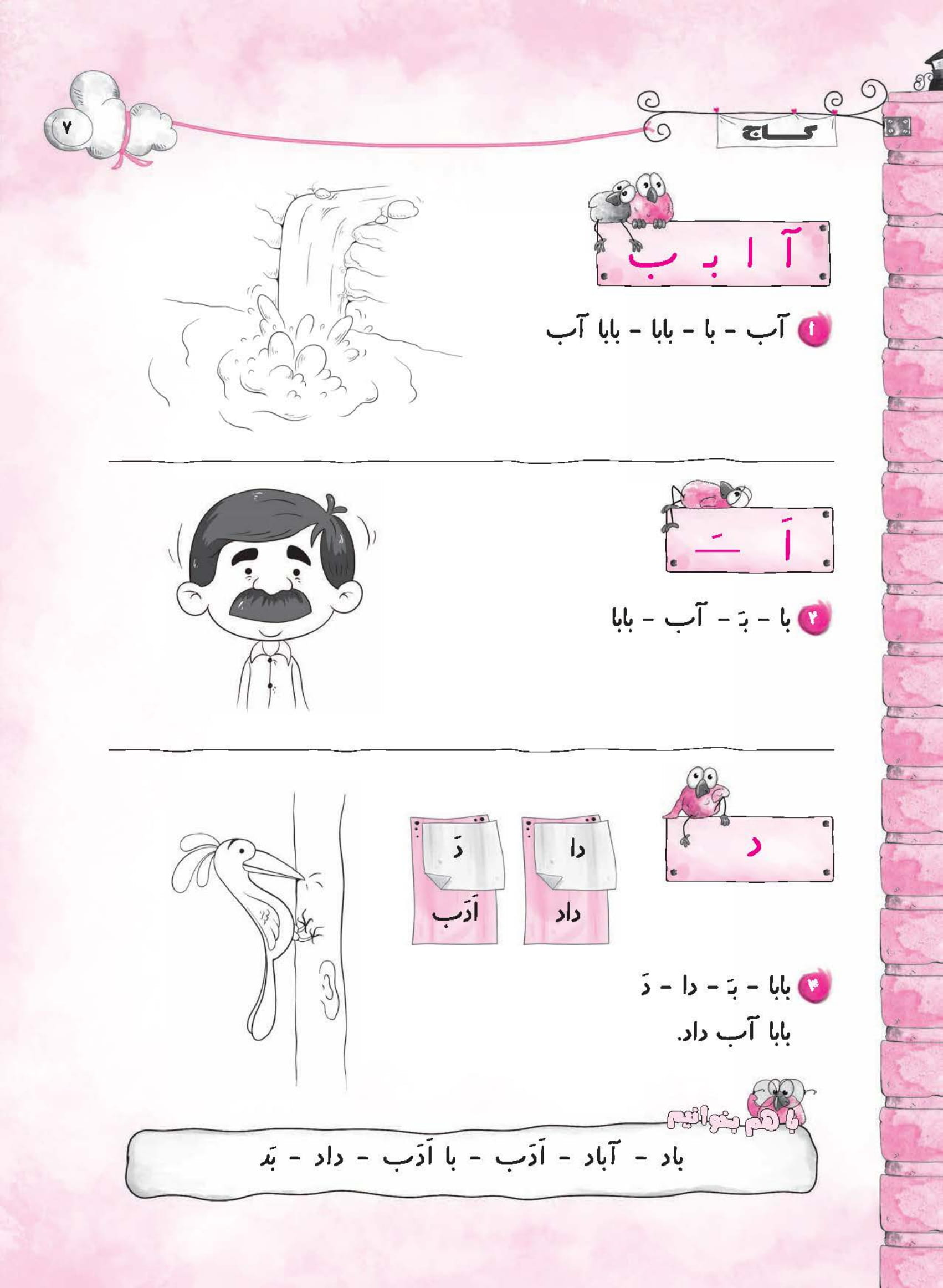

دانلود آهنگ جشن الفبا کلاس اول عمو مسعود  دانلود کتاب کار دیکته شب اول ابتدایی - کتاب گاج

دانلود کتاب کار دیکته شب اول ابتدایی - کتاب گاج  دانلود آهنگ خداحافظی معلم با دانش آموزان

دانلود آهنگ خداحافظی معلم با دانش آموزان  عکس | قابی دیدنی از بازیگر زن پُرحاشیه در حرم امام رضا(ع)

عکس | قابی دیدنی از بازیگر زن پُرحاشیه در حرم امام رضا(ع)  دانلود آهنگ خاص و بی نظیر اجتماعی سارینا از شاهین نجفی

دانلود آهنگ خاص و بی نظیر اجتماعی سارینا از شاهین نجفی  بلایی که ناخن کاشت سرتان می آورد / راهکار پیشگیری و درمان قارچ کاشت ناخن + فیلم

بلایی که ناخن کاشت سرتان می آورد / راهکار پیشگیری و درمان قارچ کاشت ناخن + فیلم  ببینید | واکنش تحسینبرانگیز رانندههای ایرانی هنگام شنیدن صدای آژیر آمبولانس

ببینید | واکنش تحسینبرانگیز رانندههای ایرانی هنگام شنیدن صدای آژیر آمبولانس  وقتی نمک شرکت کننده بیشتر از مهران مدیری/همه از خنده رفتند روی هوا + فیلم

وقتی نمک شرکت کننده بیشتر از مهران مدیری/همه از خنده رفتند روی هوا + فیلم  انواع فونت و متن بسم الله الرحمن الرحیم برای بیو اینستا

انواع فونت و متن بسم الله الرحمن الرحیم برای بیو اینستا